课程介绍

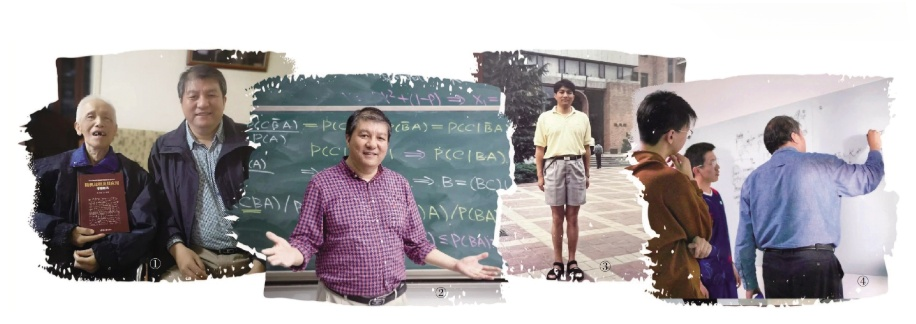

张灏老师是本人听过讲课讲的最好的老师,上课不会带任何书本或讲稿,每节课都在像讲故事一样讲数学,从张灏老师的课程中能感受到浓浓的工程师思维,并不会拘谨于定义定理的条条框框,而是按照逻辑穿针引线的将知识串起来,由此发现知识背后隐含的哲学思想,这也是张老师讲课的宗旨:每节课让学生学会一种思想。

张灏老师所讲的数字信号处理、随机过程、现代信号处理(二)课程本人之前都学过一些,最近发现张老师的信号处理(一)课程还没有学过,并且最近需要补充一些估计和机器学习的理论,所以才学习该课程,该课程虽说是现代数字信号处理,但是讲的偏统计,更像统计推断和机器学习的结合。

选学了部分的现代信号处理(一),这里的笔记同样有现代信号处理(二)的内容。

由于张老师讲课不重点强调定义定理,所以从头到尾整理张老师的推导是非常大的工程量,本人将贴出学习笔记,并在重点部分加以补充。

参考视频:

推荐视频:

推荐阅读:张颢:在讲台之上,与热爱同行

张颢老师对于能熟练的推导公式说:“无他,惟手熟尔。”听张老师的课程一行一行的写下来,并且时常温习,将会带来很大的收获。

最佳线性无偏估计

有一本小册子,推荐大家阅读:Best Linear Unbiased Estimation

定义(最佳线性无偏估计(BLUE,Best Linear unbiased estimator)). 设 $\hat{\theta}$ 是参数 $\theta$ 的线性无偏估计。如果对 $\theta$ 的任意一个线性无偏估计 $\theta^{*}$ ,有 $\operatorname{var}\left(\theta^{*}\right) \geq \operatorname{var}(\hat{\theta})$ ,则称 $\hat{\theta}$ 是参数 $\theta$ 的 BLUE 。

对于高维回归问题,我们不能比较方差,只能对比协方差矩阵,那么针对于协方差矩阵,如何定义这个最优性呢,我们需要引入关于半正定矩阵的一种度量。

Definition (Loewner order). For two positive semidefinite matrices $\Sigma_1$ and $\Sigma_2$ of the same size, we say that $\Sigma_1>\Sigma_2$ if $\Sigma_1-\Sigma_2$ is positive definite, and that $\Sigma_1 \geq \Sigma_2$ if $\Sigma_1-\Sigma_2$ is positive semidefinite.

容易证明,UMVUE的协方差矩阵正是上述定义意义下的最小。则对于高维回归分析,最佳的估计量的协方差矩阵在上意义下最小,我们需要做的就是求出该UMVUE。首先铺垫以下定理:

定理(UMVUE 的充要条件,Rao 1952) 设 $X \sim P_\theta$ 为参数空间 $\Theta$ 上的一个统计模型,定义在样本空间 $\mathcal{X}$ 上。设 $\hat{\theta}(X)$ 是参数 $\theta$ 的一个无偏估计量,即对所有 $\theta \in \Theta$ ,有:

$$

\mathbb{E}_\theta[\hat{\theta}(X)]=\theta

$$

则以下两个命题等价:

1.$\hat{\theta}(X)$ 是 $\theta$ 的 UMVUE(在所有无偏估计量中具有最小方差);

2.对于所有满足 $\mathbb{E}_\theta[U(X)]=0$ 的统计量 $U(X)$ ,都有:

$$

\operatorname{Cov}_\theta(\hat{\theta}(X), U(X))=0 \quad \forall \theta \in \Theta \text {. }

$$

Gauss-Markov定理高斯我们,BLUE就是普通的最小二乘解:

Theorem 5(Gauss-Markov定理). Let $\mathbf{X} \in \mathbb{R}^{n \times p}$ be of rank $p$, and let $$ \mathbf{y}=\mathbf{X} \boldsymbol{\beta}+\sigma \boldsymbol{\epsilon}, \boldsymbol{\epsilon} \sim P $$ for some $(\boldsymbol{\beta}, \sigma, P) \in \mathbb{R}^p \times \mathbb{R}^{+} \times \mathcal{P}$, where $\mathcal{P}$ is a class of mean-zero isotropic distributions on $\mathbb{R}^n$. If $\check{\boldsymbol{\beta}}$ is a linear unbiased estimator of $\boldsymbol{\beta}$ so that $E[\check{\boldsymbol{\beta}}]=\boldsymbol{\beta}$ for all $(\boldsymbol{\beta}, \sigma, P) \in \mathbb{R}^p \times \mathbb{R}^{+} \times \mathcal{P}$, then $$ \operatorname{Var}[\check{\boldsymbol{\beta}}] \geq \operatorname{Var}[\hat{\boldsymbol{\beta}}], $$ where $\hat{\boldsymbol{\beta}}$ is the OLS estimator.

最小二乘是BLUE,这是非常non-trivial的点,因为OLS没有考虑任何的相关性,只是使得协方差矩阵的迹最小,而BLUE是协方差矩阵意义上的最小。

线性估计的正交性原理

该章节主要引出Wiener滤波和Wiener-Hopf方程,与常规滤波器的介绍方式不同,这节的介绍更偏向于统计,给出了统计形式的Wiener-Hopf方程。

平稳随机序列线性估计

上一个小节我们得到了Winener-Hopf方程,但是对于硬件结构来说,矩阵求逆是一个非常大的开销,我们自然有想法对该求逆矩阵进行研究。

卡尔曼滤波

Wiener的思想是将系统视为黑箱,但是有些时候我们需要知道系统内部的一些情况,才可以更好的控制、以及跟踪,张老师对跟踪这一次颇有理解,认为跟踪实际上是预估-校正,这也是卡尔曼滤波的核心思想。

张老师认为卡尔曼滤波有三个核心思想:1.将黑箱系统变为白箱。2.预估校正法。3.残差推断。

核方法

主要讲述SVM和Kernel,参考张老师的课堂和李航的《统计学习方法》。

正则化

机器学习中的经典概念,这里主要设计 $L_1$ 和 $L_2$ 正则化的推导,分析bias和var的trade-off,并介绍了和贝叶斯建模的联系。

LMS算法

一阶优化算法

递归最小二乘(RLS)

凸优化基础

阵列信号处理

现代数字信号处理(二)中的阵列信号处理部分。

DOA估计

DOA估计的 C-R Bound

依托于点估计中的C-R Bound ,张老师用一整节课对DOA基本模型求Fisher信息矩阵,错误还是蛮多的,不过很受益,以后还是要系统的学一下多元微积分,只靠数学分析的基础还是远远不够的。

MIMO

久闻大名的MIMO技术,这里仅仅从信道容量视角介绍MIMO,并无具体算法的介绍,以后有机会一定要学一下MIMO的东西,还是挺有意思的。

时频分析

比较传统的信号处理内容,现在几乎很少用时频分析来分析信号,本科期间曾经学习过信号与系统、数字信号处理、通信原理这些时频分析的课程,一直很疑惑这种方法在如今是否有什么用途,于是学了这个章节的内容,张老师由该章节直接引出了压缩感知和稀疏恢复,还是很惊喜的。

STFT和 Wigner-Ville 变换

小波分析和 Paserval frame

稀疏信号处理

贝叶斯信号处理

之前整理过,见另一篇博客.